llms.txt: Die Weichenstellung für Künstliche Intelligenz auf Ihrer Webseite

Die llms.txt ist eine vorgeschlagene Textdatei, die speziell darauf abzielt, den Zugriff von Large Language Models (LLMs) auf Websites zu steuern. Anders als etablierte Standards wie die robots.txt genießt llms.txt derzeit keinerlei offiziellen Status und wird von gängigen KI-Crawlern nicht aktiv berücksichtigt. Ihre praktische Bedeutung ist somit aktuell nahezu null.

Dennoch eröffnet die Idee Diskussionsmöglichkeiten über den Schutz digitaler Inhalte im Kontext von KI. Dieser Beitrag beleuchtet die Grundlagen der llms.txt, ihre potenziellen Anwendungsmöglichkeiten, die Vorteile und Herausforderungen sowie Perspektiven für die Zukunft, in der solche Konzepte an Relevanz gewinnen könnten.

- Inhalte

-

- Was ist llms.txt?

- Warum sind LLM-spezifische Steuerungsmechanismen relevant?

- Warum LLM-spezifische Steuerung?

- LLM-Direktiven als Erweiterung der robots.txt

- Funktionsweise und Syntax

- Mögliche zukünftige Direktiven

- Spezifische Steuerungsoptionen für LLM-Bots

- Wichtige User-Agents von LLM-Crawlern

- Schritt-für-Schritt-Anleitung

- Wer unterstützt LLM-spezifische Direktiven in robots.txt?

- Die Zukunft von llms.txt und der Steuerung von KI-Crawlern

- Fazit und Handlungsempfehlungen

Was ist llms.txt?

Der Begriff llms.txt beschreibt die konzeptionelle Idee einer speziell formatierten Textdatei (oder eines Satzes von Regeln), die Webseitenbetreibern Kontrolle darüber gibt, wie ihre Inhalte von KI-Systemen, sogenannten LLMs, verwendet werden.

Aktuell erfolgt diese Steuerung in der Praxis jedoch primär durch spezifische Einträge für LLM-User-Agents in der etablierten robots.txt-Datei.

Diese LLM-spezifischen Regeln innerhalb der robots.txt (oder einer zukünftigen, dedizierten llms.txt) richten sich spezifisch an Bots von LLM-Anbietern wie OpenAI (GPTBot), Google (Google-Extended) oder Anthropic (ClaudeBot und anthropic-ai). Mit dem zunehmenden Einsatz von KI in verschiedenen Branchen wird es immer wichtiger, die Nutzung digitaler Inhalte zu regulieren – ein zentraler Bestandteil moderner KI-SEO-Strategien.

Warum sind LLM-spezifische Steuerungsmechanismen relevant?

Die rasante Entwicklung von KI-Tools hat den Bedarf an Trainingsdaten enorm gesteigert. LLM-Bots durchsuchen das Web, um Inhalte für die Verbesserung ihrer Modelle zu sammeln. Dies birgt Risiken, wie unautorisierte Nutzung urheberrechtlich geschützter Inhalte oder erheblichen Serverstress durch intensives Crawling. Steuerungsmechanismen ermöglichen, diese Probleme zu adressieren, indem sie den Zugriff regeln und den Missbrauch von Daten einschränken.

Zielsetzung von LLM-spezifischen Steuerungsmechanismen (aktuell meist via robots.txt):

- Schutz sensibler Inhalte vor unerwünschtem Training durch LLMs

- Kontrolle der Verwendungszwecke (z. B. ob Inhalte für Training genutzt oder in Ausgaben reproduziert werden dürfen – aktuell primär durch pauschales Blockieren umgesetzt)

- Wahrung des Copyrights und Unterstützung bei der Vermeidung von rechtlichen Konflikten

- Schonung von Serverressourcen durch gezielte Crawler-Steuerung

Warum LLM-spezifische Steuerung? Die Notwendigkeit im Zeitalter der KI

Mit dem Aufkommen generativer KI-Systeme stehen Webmaster vor neuen Herausforderungen. Klassische Mechanismen wie die robots.txt allein reichen oft nicht aus, um KI-spezifische Zugriffe ausreichend differenziert zu steuern. Die wichtigsten Probleme sind:

LLM-Direktiven als Erweiterung der robots.txt

Während robots.txt ein bewährtes Tool für die Steuerung von Suchmaschinen-Crawlern ist, bieten spezifische Direktiven für LLM-User-Agents (meist in der robots.txt) zusätzliche Kontrolle über KI-spezifische Anliegen. Webmaster können damit nicht nur den Zugriff auf Inhalte regulieren, sondern implizit auch deren Verwendungszweck (z.B. für Training) beeinflussen, indem sie den Zugriff für bekannte LLM-Crawler unterbinden.

| Feature | robots.txt (traditionell) | LLM-Direktiven (in robots.txt) |

|---|---|---|

| Bots | Allgemeine Crawler | Steuerung der Datennutzung (Training etc. durch Zugriffsblockade) |

| Hauptzweck | Indexierungssteuerung | Steuerung der Datennutzung (Training etc. durch Zugriffsblockade) |

| Granularität | Pfad-basiert | Pfad-basiert (die "Nutzungsart" wird durch das Blockieren des spezifischen User-Agents gesteuert; zukünftige Standardskönnten hier mehr Optionen bieten) |

Diese Tabelle zeigt die komplementäre Funktion. LLM-spezifische Einträge in der robots.txt erlauben eine präzisere Regulierung für die Anforderungen moderner KI-Crawler.

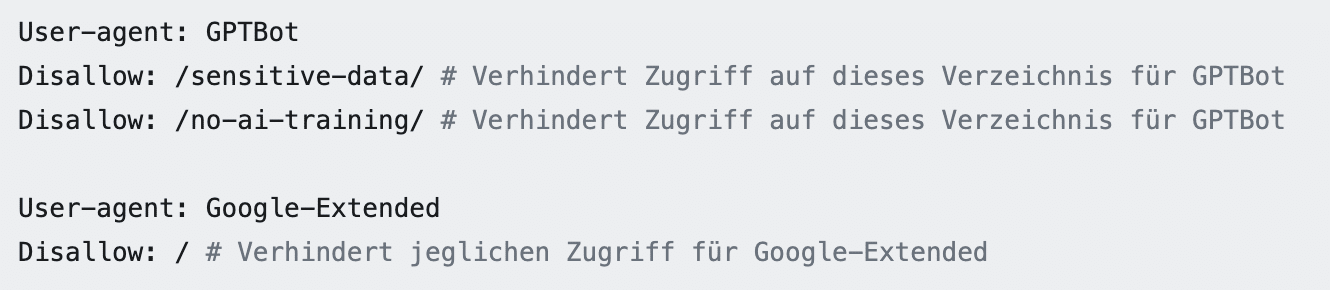

Visuelles Beispiel einer robots.txt mit LLM-Anweisungen:

Funktionsweise und Syntax von LLM-spezifischen robots.txt-Einträgen

Obwohl eine separate llms.txt-Datei im Stammverzeichnis (z.B. https://www.beispielseite.de/llms.txt) die logische Platzierung für einen zukünftigen, dedizierten Standard wäre, werden aktuell die Regeln für LLM-Bots in die bestehende robots.txt-Datei im Stammverzeichnis integriert. Ihre Struktur und Syntax folgt dabei den bekannten robots.txt-Konventionen:

Aufbau und Grundlegende Direktiven (in robots.txt)

- User-agent: Gibt an, für welche LLM-Bots (z. B. GPTBot) die nachfolgenden Regeln gelten.

- Disallow: Verhindert den Zugriff auf spezifische Bereiche (Dateien oder Verzeichnisse), z. B. /private-data/. Ein Disallow: / sperrt die gesamte Seite für den genannten User-Agent.

Allow: Hebt Sperren für bestimmte Unterverzeichnisse oder Dateien auf, falls ein übergeordnetes Verzeichnis per Disallow gesperrt ist (nur bei Bedarf und mit Vorsicht zu verwenden).

Mögliche zukünftige Direktiven (für einen Standard wie llms.txt)

Diese sind aktuell noch nicht etabliert, aber in der Diskussion:

- NoTraining: Könnte explizit verbieten, die Inhalte für Modell-Training zu verwenden, auch wenn der Crawler sonst zugreifen darf.

- NoOutputReproduction: Könnte untersagen, dass Inhalte direkt in KI-Ausgaben erscheinen.

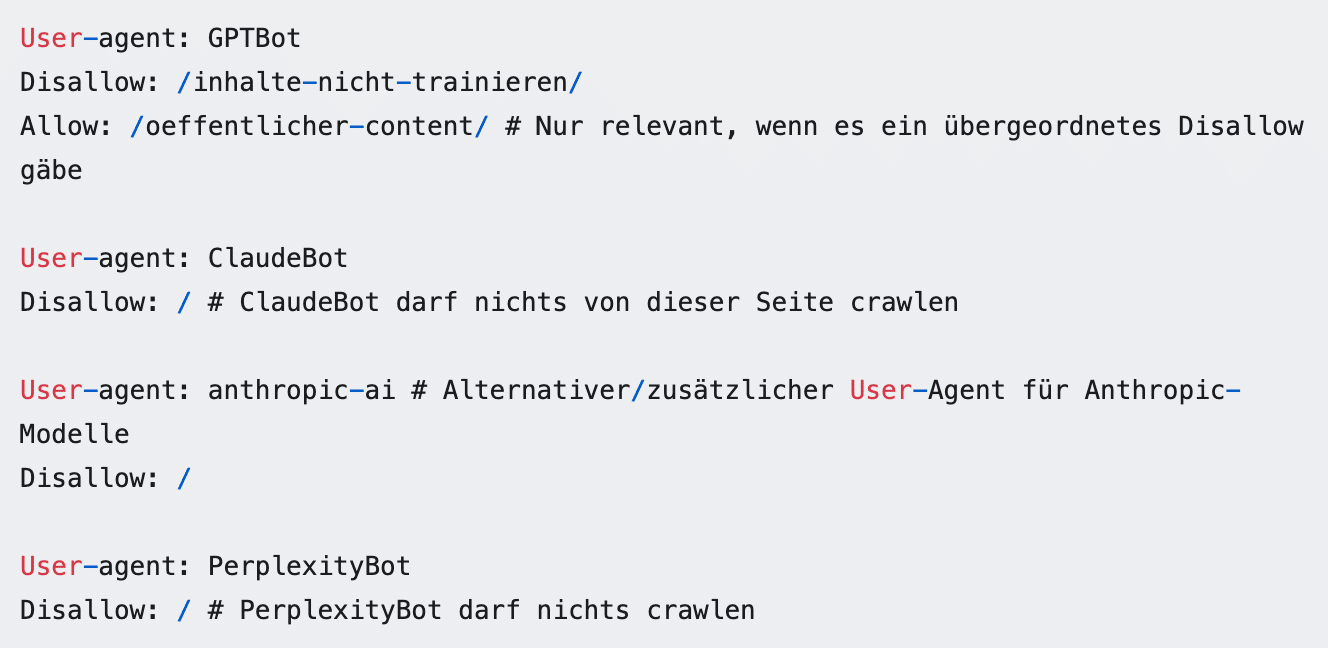

Beispiel-Syntax in robots.txt:

Spezifische Steuerungsoptionen für LLM-Bots

Eine hypothetische, zukünftige llms.txt-Datei oder Erweiterungen bestehender Protokolle könnten noch granularere Kontrollmöglichkeiten wie spezifische Nutzungsanweisungen (z.B. nur zur Indexierung für eine interne KI-Suche, aber nicht zum Training globaler Modelle) oder Rate-Limiting für Crawler enthalten. Solche Standards könnten sich in Zukunft entwickeln.

Wichtige User-Agents von LLM-Crawlern (Stand: Mai 2025)

Es ist entscheidend, stets mit den aktiven User-Agents von KI-Bot-Diensten vertraut zu sein, um die robots.txt effektiv zu gestalten:

| Anbieter | User-Agent(s) | Dokumentation (Beispielhafte Links) |

|---|---|---|

| OpenAI | GPTBot | OpenAI GPTBot Docs |

| Google-Extended | Google Crawler Docs | |

| Anthropic | ClaudeBot, anthropic-ai | Anthropic Robots Info |

| Perplexity AI | PerplexityBot | PerplexityBot Docs |

| Common Crawl | CCBot | Common Crawl Robots Info |

Tipp: Beobachten Sie Ihre Serverlogs, um neue oder hier nicht gelistete Bots zu identifizieren und entsprechende Regeln in Ihrer robots.txt hinzuzufügen. Die Dokumentationen der Anbieter sind die primäre Quelle für korrekte User-Agent-Namen.

Implementierung: Schritt-für-Schritt-Anleitung zur Anpassung Ihrer robots.txt

Tools zur Unterstützung:

- Serverlog-Analysetools (z.B. AWStats, Matomo Logs Analytics, oder serverseitige Lösungen) zum Identifizieren von Crawler-Aktivitäten

- Online-Testtools für robots.txt

- Eine professionelle GEO-Agentur kann bei der Einrichtung unterstützen

Wer unterstützt LLM-spezifische Direktiven in robots.txt?

Die großen Anbieter wie OpenAI, Google und Anthropic haben sich dazu verpflichtet, robots.txt-Anweisungen, einschließlich der für ihre spezifischen User-Agents (GPTBot, Google-Extended, ClaudeBot/anthropic-ai), zu respektieren. Dennoch bleibt die Einhaltung der robots.txt generell freiwillig. Insbesondere weniger seriöse oder unbekannte Bots ignorieren diese Richtlinien häufig. Die genaue Interpretation, was z.B. unter „für Training verwenden“ fällt, kann sich zudem zwischen Anbietern unterscheiden und ist nicht immer transparent.

Vorteile der Nutzung von LLM-spezifischen Anweisungen in robots.txt

- Kontrolle über Inhalte: Sie signalisieren klar, welche Daten nicht für KI-Training durch die spezifizierten Bots verwendet werden sollen.

- Schutz geistigen Eigentums: Ein wichtiger Schritt, um die unautorisierte Nutzung urheberrechtlich geschützter Werke zu erschweren.

- Server-Ressourcen-Management: Kann unnötige Serverlast durch intensive Crawling-Aktivitäten der genannten Bots reduzieren.

- Rechtlicher Nachweis (bedingt): Die Steuerung zeigt den Willen des Website-Betreibers zum Schutz seiner Inhalte und kann in rechtlichen Auseinandersetzungen eine (unterstützende) Rolle spielen.

- Zukunftssicherheit und Verhandlungsposition: Klare Regeln können eine Basis für zukünftige Lizenzierungsmodelle für KI-Trainingsdaten sein.

Herausforderungen und Limitationen

- Freiwilligkeit: robots.txt-Anweisungen sind eine Bitte, keine technische Barriere. Bots können sie ignorieren.

- „Bösartige“ oder unbekannte Bots: Crawler, die explizit darauf ausgelegt sind, Regeln zu missachten, oder neue, noch nicht identifizierte LLM-Bots werden nicht erfasst.

- Kein rückwirkender Schutz: Inhalte, die bereits vor der Implementierung der Regeln gecrawlt wurden, sind potenziell schon in Modellen enthalten.

- Komplexität bei Granularität: Sehr detaillierte und unterschiedliche Regeln für viele Bots können die robots.txt komplex machen.

- Aktualisierungsaufwand: Die Liste der relevanten User-Agents und deren Verhalten kann sich ändern und erfordert kontinuierliche Pflege.

Die Zukunft von llms.txt und der Steuerung von KI-Crawlern

Die Entwicklung neuer Standards wie einer spezifizierten llms.txt-Datei oder spezifischerer Direktiven wird in Fachkreisen bereits diskutiert.

Eine separate llms.txt könnte sinnvoll sein, um komplexere, LLM-spezifische Regeln zu definieren (z.B. NoTraining, RateLimit), die den Rahmen der traditionellen robots.txt sprengen würden oder eine klarere Trennung der Anweisungen für Suchmaschinen und LLMs ermöglichen.

Parallel dazu gibt es Diskussionen um andere technische Signale, wie z.B. das TDM Reservation Protocol (TDMRep), das oft als HTML-Meta-Tag oder HTTP-Header implementiert wird und explizit die Rechte für Text and Data Mining (TDM) regeln soll.

Mögliche Erweiterungen könnten auch Metadaten in CMS-Systemen oder APIs für lizenzierten Datenzugriff umfassen. Bis dahin bleibt die sorgfältige Konfiguration der robots.txt zunächst die wichtigste Grundlage.

Fazit und Handlungsempfehlungen

Die Steuerung der Nutzung von Web-Inhalten durch Large Language Models ist ein wichtiger und notwendiger Schritt für moderne Webseitenbetreiber. Durch proaktives Management Ihrer robots.txt mit spezifischen Anweisungen für LLM-User-Agents sichern Sie nicht nur Ihre Rechte besser ab, sondern bereiten sich auch auf künftige Entwicklungen im KI-Bereich vor.

Was Sie jetzt tun können:

Obwohl diese Maßnahmen keinen hundertprozentigen Schutz garantieren, ist die aktive Steuerung ein essenzieller Bestandteil des digitalen Content-Managements im Zeitalter der Künstlichen Intelligenz. Es ist auch ratsam, die rechtlichen Rahmenbedingungen im Auge zu behalten, da diese sich im Kontext von KI und Urheberrecht dynamisch entwickeln.